Selon Piéron (Vocabulaire de la Psychologie, 1951), la validité empirique s'évalue par le degré de liaison entre le rendement du sujet dans un test et son rendement dans une autre activité que le test est censé prévoir.

Dans cette perspective, le test est considéré comme un instrument qui sert à prédire un comportement qu'on appelle le critère. La validation est l'étude de la relation entre le test et ce critère.

Le terme de validité empirique, habituellement utilisé en France, recouvre ce que les anglo-saxons appelle validité de critère, validité critériée ou encore validité pragmatique. Pour établir la validité empirique d'un test x par rapport à un critère y, on se sert d'un échantillon représentatif de la population à laquelle on destine le test et on détermine le degré de covariation entre le test et le critère en utilisant par exemple le coefficient de corrélation de Bravais-Pearson que l'on appelle alors parfois le coefficient de validité.

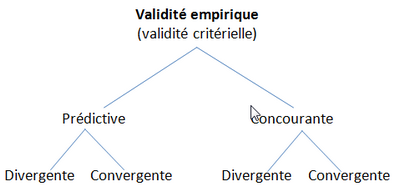

On distingue deux types de validation empirique :

®Validité concourante (concurrent validity) : la mesure en question (test) et le critère ou les critères sont étudiés simultanément. Une corrélation forte entre le test et ces critères permettra d'affirmer qu'il existe une validité concourante (convergente ou concomitante sont des termes aussi utilisé).

®Validité prédictive : elle concerne un critère futur qui peut être corrélé avec la mesure. Il existe donc un délai entre la mesure effectuée avec une épreuve (un test) et l'évaluation sur le critère. Le test sert à pronostiquer (prédire) le critère qui sera évalué ultérieurement sur le plan empirique (par exemple, la réussite scolaire un an plus tard).

Pour chacune de ces validations empiriques, on distingue aussi la validité convergente et la validité divergente.

®La validité convergente vise à estimer la validité d'un test par sa ressemblance avec d'autres mesures considérées comme similaires.

®La validation divergente, par contraste, confirme la validité d'un test par la divergence (corrélation nulle par exemple) des résultats qu'on obtient entre le test et d'autres tests ou critères dont on fait l'hypothèse qu'ils mesurent autre chose. Cette méthode complémentaire à la validité convergente permet de s'assurer que la variance vraie associée au test (les différences réelles observées) est pour l'essentiel associée au construit que l'on souhaite mesurer et non à un autre construit. Par exemple, lors de la construction d'une épreuve voulant évaluer l'aptitude verbale, la présentation comme la nature des items peut laisser penser que le test est en lien avec d'autres aptitudes (visuo-spatiale, raisonnement, etc.). La validité divergente permettra de s'assurer que le test est peu ou pas corrélé avec ces autres construits.

Figure E.11 : Les différentes formes de validité empiriques

Remarque

La validité du test dépend de la fidélité aussi bien du test que du critère. Il est évident que si le classement des sujets dans l'une et/ou l'autre des variables est arbitraire, le coefficient de validité sera nul ou très faible. Un des problèmes réside dans le fait qu'il est souvent difficile d'obtenir des critères fidèles. L'utilisation de la correction pour atténuation lors du calcul de la corrélation permet de tenir compte (pour interpréter la relation entre test et critère) de la fidélité du test et du critère.